La digital transformation nelle aziende, sta portando queste ultime a scegliere soluzioni cloud sempre più frequentemente: costi, gestione, scalabilità, sono solo alcuni dei vantaggi che un'architettura di questo tipo può offrire.

Tra i vari parametri che devono guidare la scelta sul tipo di cloud, ce n'è uno che a volte viene sottovalutato: il tempo di disponibilità del servizio, chiamato anche uptime.

Molto spesso infatti le architetture cloud di un cliente hanno componenti (o sono totalmente realizzate) presso data center esterni: le motivazioni possono essere molteplici, non le prendo in considerazione ora.

Focalizziamoci quindi su uno scenario sempre più frequente: un'azienda che si affida ad una struttura cloud presso un data center di un fornitore esterno.

In questi casi, uno dei parametri da valutare, è appunto l'uptime che il fornitore dichiara (e che deve certificare....).

Perché l'uptime è così importante?

E' presto detto: il tempo di inattività del data center si riflette come conseguenza sull'inattività delle funzioni aziendali legate a quei servizi. Tanto più sono "core", importanti, i servizi posti nel data center esterno, tanto più l'uptime gioca un ruolo chiave.

Non c'è una regola in questo: ciascuna realtà deve valutare costi, benefici ed impatti, che questo comporta.

E' sufficiente un uptime del 99,9%? Spesso, letto così, sembra più che sufficiente. Ma proviamo ad analizzare alcuni scenari.

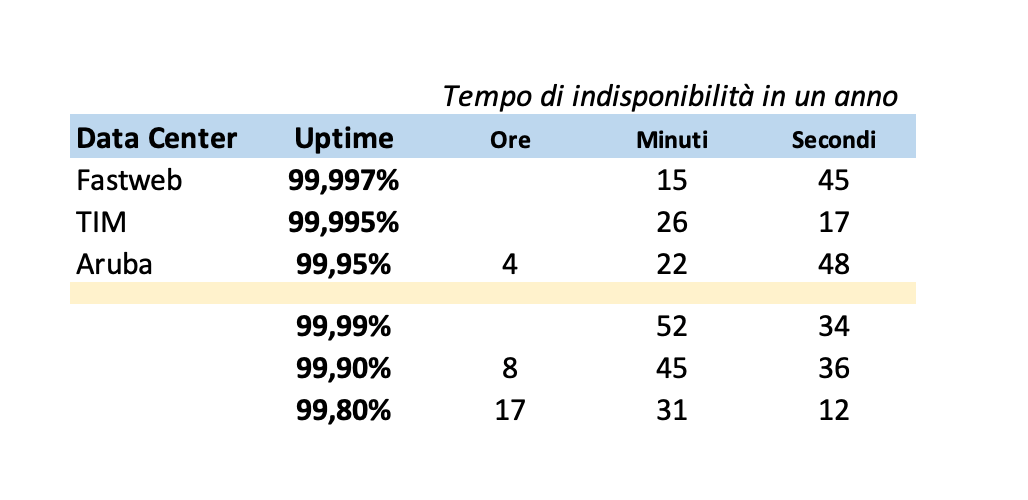

Ho preso come riferimento gli uptime di 3 data center di provider nazionali:

- Fastweb: Data Center Caracciolo, TIER 4, uptime 99,997% (fonte qui)

- TIM: Data Center Acilia, TIER 4, uptime 99,995% (fonte qui)

- Aruba: Data Center Arezzo IT1, ANSI/TIA Rating 4, uptime 99,95% (fonte qui)

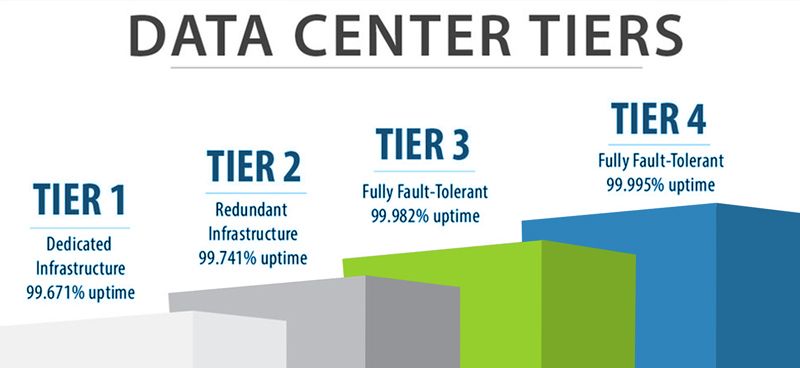

La direttiva TIER 4 dell'Uptime Institute prevede che tale certificazione corrisponda ad almeno un uptime del 99,995% (oltre ad ovviamente una innumerevole serie di caratteristiche).

Se mettiamo una tabella i numeri, ecco cosa ne risulta:

Microsoft Azure e Amazon AWS?

I big player a livello globale hanno infrastrutture ridondate in tutto il mondo. Ma anche qui, i livelli di uptime certificati nei documenti vanno analizzati con cura. Amazon, ad esempio, dichiara un uptime tra il 99,0% e il 99,99%, dicendo che non scende mai sotto il 95% (vorrei vedere....!). Microsoft oscilla tra il 99,9% ed il 99,99%.

Una piccola differenza, raddoppia il tempo di indisponibilità delle risorse. Ora, la domanda da porsi è: quanto costa all'azienda il fermo delle applicazioni in cloud? Posso permettermi una mezzora o un ora di blocco delle attività?

La risposta non è semplice. Dipende da molti fattori. Dipende soprattutto quali sono i servizi in data center.

Se parliamo di applicativi - ad esempio - di collaboration, probabilmente non è necessario un uptime elevato.

Ma se invece sono applicativi che governano dispositivi IoT, piuttosto che impianti di produzione, la questione cambia: c'è molta differenza nello fermare una linea di produzione per 15 minuti piuttosto che per 3 o 4 ore.

E' quindi buona norma, quando si seleziona un partner al quale affidare le proprie applicazioni, pretendere innanzitutto che sia dichiarato l'effettivo uptime delle infrastrutture.

In secondo luogo, vanno fatte tutte le analisi del caso: un "9" dopo la virgola, può cambiare decisamente le carte in tavola.